Das FFG ist vorbei, von der CeBIT sind nun auch alle wieder zurück – beginnen wir mit der Nachlese des Frühjahrsfachgesprächs! Auf die Keynote mit Kurt Garloff gehen wir hier noch gesondert ein. Stattdessen starten wir mit dem Rückblick auf den ersten FFG-Tag mit drei parallel laufenden Tracks ever:

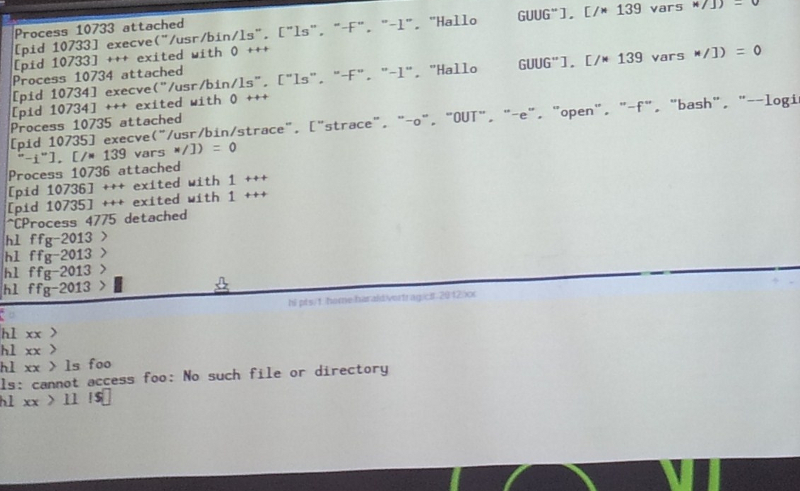

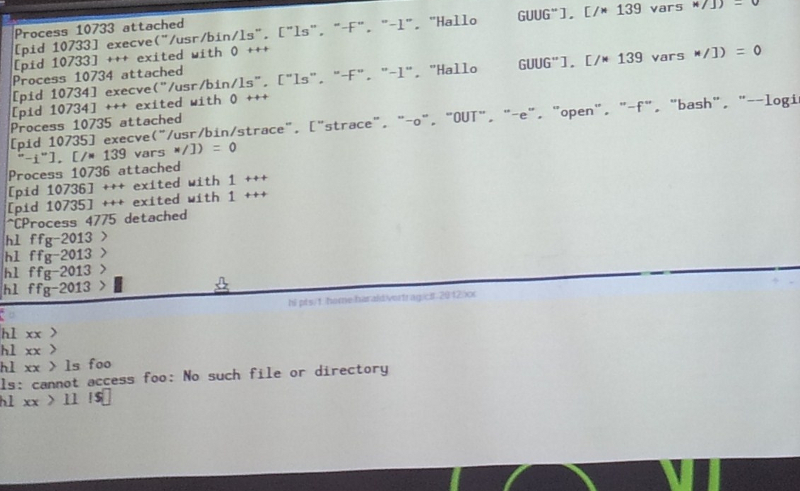

Erkan Yanar machte mit Galera den Anfang (s. Interview | Slides), außerdem sprachen Christian Bockermann über die komplexen Logfiles von Web Application Firewalls (Proceeding | Slides) und Kurt Pfeifle vor großem Publikum über PDF Debugging. Es folgten Andrea Held – ab morgen übrigens bei den Frankfurter Datenbanktagen aktiv – mit Oracle Migration (Slides), Andreas Bunten und Thorsten Voss mit „SSH-Angreifern mit Honeypots über die Schulter schauen“ (Slides) und wie in jedem Jahr: Harald König und strace (Slides):

„Die Folien sind gleich vorbei, dann kommt nur noch Xterm und Kommandozeile.“ – wie immer bei Harald & strace. Foto: Corina Pahrmann (CC-BY-SA)

„Die Folien sind gleich vorbei, dann kommt nur noch Xterm und Kommandozeile.“ – wie immer bei Harald & strace. Foto: Corina Pahrmann (CC-BY-SA)

Nach der Mittagspause empfahl Thomas Gelf in seinem Puppet-Vortrag, unbedingt einmal MCollective auszuprobieren: „Vorher aber wichtig: Ihr solltet verstehen, wie es funktioniert.“ – Und gab sogleich eine Einführung in das Konfigurationsmanagementtool. Und eine wichtige Aussage: „Puppet ist frei. Und Puppet bleibt frei.“ (Slides)

In den beiden anderen Tracks sprachen Matthijs Mekking über DNS Rate Limiting (Slides) und Ralf Spenneberg über das im Auftrag des BSI entwickelte Tool TacNET. Hintergrund: Um Unternehmensnetzwerke sicherer zu machen, müssen alle Mitarbeiter – insbesondere die Admins – unter realistischen Bedingungen geschult werden. Die dazu benötigten komplexen Netzwerkstrukturen werden nun mit Hilfe von TacNET virtualisiert. Es entsteht eine Trainingsumgebung, über die der Dozent auch Angriffe simulieren kann (Slides).

Nächster Höhepunkt: Michael Messner, der kürzlich erst einige Sicherheitslöcher in Routern aufdeckte, erzählte in einem ebenso amüsanten wie erschreckenden Vortrag einige „Home Network Horror Stories“: Default-Passwörter, die durchs Web geistern, viel zu leicht veränderbare Zugangsdaten, eine command.php, die sich ohne Authentifizierung aufrufen lässt. „Die Sicherheitsverbrechen der letzten 15 Jahre finden wir in unseren Geräten“, lautete Michaels Resüme. Und dass große Router-Hersteller erst aktiv werden, nachdem die Presse eingeschaltet ist, ist letztlich nicht gerade aufmunternd. Umso beeindruckender der Tüftelwille, von dem Michael immer wieder angetrieben wird (Interview | Slides). In den anderen Räumen derweil: Oliver Rath, in diesem Jahr zu alternativen Virtualisierungslösungen (Slides), und Philipp Grau zum OS-Konfigurationsmanagement-Tool Ansible (Slides).

Ein Router-Passwort fand Michael Messner bei Google: als ersten Treffer. Foto: Corina Pahrmann (CC-BY-SA)

Ein Router-Passwort fand Michael Messner bei Google: als ersten Treffer. Foto: Corina Pahrmann (CC-BY-SA)

Nach der Kaffeepause warteten noch weitere neun Vorträge auf die FFG-Teilnehmer: Um Netzwerkadministration und -sicherheit ging es bei

- Bernd Erk: spannendes Update zu Icinga/Icinga2 für alle Zuhörer inklusive der Einladung, selbst an der Entwicklung mitzuarbeiten (Slides)

- Robin Schröder: ein Einblick ins Netz der Ruhr-Uni Bochum „HIRN“ (Slides | Proceeding)

- und Stefan Gazdag: aus der Praxis mit dem Monitoringtool Zabbix (Slides).

Track 2 begann mit Alexander Koderman und den Herausforderungen um eine Evaluierung (Slides). Danach folgten zwei IPv6-Vorträge, die wieder einmal die Haupteigenschaft des FFGs bewiesen: absolut kompetente Referenten, die wiederum mit absolut praxiserfahrenen Teilnehmern diskutieren. Christoph Wegener – auch im GUUG-Vorstand – und Jörg Heidrich widmeten sich der Datenschutzproblematik um bei IPv6, Marc Haber tauschte sich mit dem Publikum zu den gelösten Problemen von IPv4 und neuen Problemen von IPv6 aus (Slides | Proceeding). Sessions dieser Art wollen wir immer wieder auf dem FFG sehen.

In Track 3 nochmal geballtes Know-how „in der Cloud“:

- Christian Schneemann stellte Datensharing mit ownCloud vor (Slides)

- Martin Loschwitz die eigene Cloudlösung mit OpenStack Folsom (Slides)

- und Christian Berendt zeigte den Aufbau einer IaaS-Umgebung mit OpenStack (Slides).

Der erste Vortragstag endete dann wenige Tramstationen weiter in der Friedberger Warte. War sehr nett mit Euch! Rückblick auf Tag 4 & die Keynote folgen in Kürze an dieser Stelle.

P.S.: Eindrücke vom FFG2013 gibt es auch bei Dirk Deimeke.

Text: Corina Pahrmann

Veranstaltungsort: TU Chemnitz, Gebäude an der Reichenhainer Straße 90 (Foto: Wikipedia/Kolossos, CC-BY-SA)

Veranstaltungsort: TU Chemnitz, Gebäude an der Reichenhainer Straße 90 (Foto: Wikipedia/Kolossos, CC-BY-SA)

Kurt Garloff sprach bei seiner Keynote …

Kurt Garloff sprach bei seiner Keynote … … vor vollbesetztem Hörsaal

… vor vollbesetztem Hörsaal „Die Folien sind gleich vorbei, dann kommt nur noch Xterm und Kommandozeile.“ – wie immer bei Harald & strace. Foto: Corina Pahrmann (CC-BY-SA)

„Die Folien sind gleich vorbei, dann kommt nur noch Xterm und Kommandozeile.“ – wie immer bei Harald & strace. Foto: Corina Pahrmann (CC-BY-SA) Ein Router-Passwort fand Michael Messner bei Google: als ersten Treffer. Foto: Corina Pahrmann (CC-BY-SA)

Ein Router-Passwort fand Michael Messner bei Google: als ersten Treffer. Foto: Corina Pahrmann (CC-BY-SA)